云数据中心是云计算的基础设施。云计算业务持续渗透,拉动云计算超大数据中心的建设。云IT基础设施主要由交换机、服务器以及互连这一切的光缆和光模块(或AOC)组成。云数据中心的大型化将极大提升光模块的使用量,同时对光模块的传输距离有了更高的要求,这将增加单模光模块的使用比例。

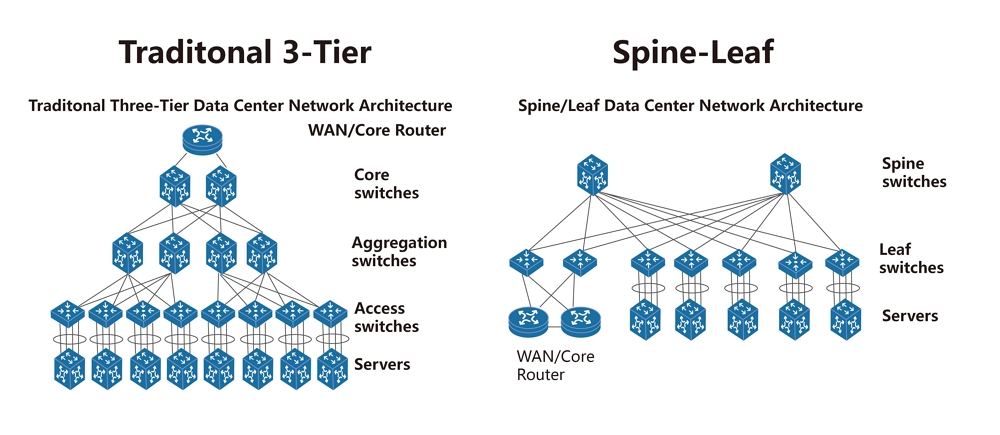

云数据中心流量的爆发式增长,驱动了光模块工作速率不断升级,并呈加速态势。10G速率端口迭代到40G速率端口经历了5年,40G速率端口升级到100G速率端口经历了4年,而100G速率端口到400G速率端口或仅需3年时间。未来数据中心所有的出口数据都需经过内部的海量运算(尤其是AI等应用的崛起,内部流量和出口流量更加惊人)。如今,数据中心普遍采用扁平化的架构使得100G光模块市场将持续高速的增长。

根据Synergy第三方报告显示,截至2016年,全球超大规模数据中心总数突破300个,2017年则超过390个,目前至少有69个超大规模数据中心处于规划或建设阶段,预测到2019年底之前,全球超大规模数据中心数量将超过500个,届时83%的公有云服务器和86%的公有云负载都将承载在超级数据中心,超级数据中心服务器部署量占比将从21%上升到47%,处理能力占比从39%提升到68%,流量占比从34%提升到53%。

数据中心传统三层架构和扁平化两层架构的对比

光模块和AOC在数据中心光互连应用实例介绍

国内某云数据中心网络架构分为超核心区交换机(Spine Core), 模组核心区域交换机(Edge Core,或称Leaf Switch)和接入交换区域交换机(TOR)。

从服务器网卡NIC到接入交换区域交换机,采用10G SFP+ AOC有源光缆互连。

从接入交换区域交换机到模组核心区域交换机,采用40GE QSFP+ SR4光模块和MPO光纤跳线互连。

从模组核心交换机到超核心区交换机,采用100G QSFP28 CWDM4光模块和LC双纤光纤跳线互连。

云数据中心端口带宽的升级趋势 (从10G到25G,再到100G)

| 部署年代 | 2008–2014 | 2013–2019 | 2017–2021 | 2019– |

|---|

| 园区,超大数据中心 | 40G LR4 | 40G LR4

100G CWDM4 | 100G CWDM4 | 400G FR4 |

| 机房内部 | 40G SR4

4x10G SR | 40G eSR4 | 100G SR4 | 400G DR4 |

| 机架内部 | CAT6 | 10G AOC | 25G AOC | 100G AOC |

| 服务器网卡速率 | 1G | 10G | 25G | 100G |

云数据中心光模块需求的特点

由于云数据中心流量增速、网络架构、可靠性要求和机房环境与电信级网络的差异,云数据中心对光模块的需求体现以下特点:迭代周期短、速率要求高、高密度、低功耗。

迭代周期短。数据中心流量高速增长,驱动光模块不断升级,并呈加速态势,包括光模块在内的数据中心硬件设备跌代周期在3年左右,而电信级光模块的迭代周期一般在6至7年以上。

速率要求高。由于数据中心流量爆发性增长,光模块的技术迭代赶不上需求,基本上最尖端的技术都应用到了数据中心。对于更高速光模块,数据中心需求一直都在,关键在于技术是否成熟。

高密度。高密度的核心是为了提高交换机和服务器单板传输容量,本质上还是为了满足流量高速增长的需求;同时,密度越大,意味着可以部署更少的交换机,以节约机房资源。

低功耗。数据中心耗电量大,低功耗一方面是为了节约能耗,另外一方面是为了应对散热问题,因为数据中心交换机背板插满了光模块,若散热问题无法妥善解决,将会影响到光模块的性能和密度的提高。

针对几大需求,鑫杰讯提供了非常全面的云数据中心光模块产品解决方案,其速率覆盖10G至100G,且距离覆盖100m至40km。